Introduction à la Conteneurisation

La conteneurisation est une méthode qui permet de packager une application et ses dépendances dans un environnement isolé, appelé conteneur. Ce concept a révolutionné le développement et le déploiement d’applications en offrant une solution efficace pour surmonter les défis liés à l’environnement et à la portabilité des logiciels. En utilisant des conteneurs, les développeurs peuvent s’assurer que leur application fonctionne de manière cohérente, quel que soit l’environnement de déploiement, qu’il s’agisse d’un ordinateur personnel, d’un serveur ou du cloud.

L’une des principales raisons pour lesquelles la conteneurisation est devenue cruciale dans le développement moderne réside dans sa capacité à simplifier la gestion des ressources. Les conteneurs permettent d’éviter les conflits de dépendances en isolant les applications les unes des autres. Cela signifie qu’un développeur peut exécuter plusieurs version de l’application simultanément sans que l’une perturbent l’autre. En outre, cette approche facilite également l’intégration continue et le déploiement continu (CI/CD), ce qui permet aux équipes de publier des mises à jour fréquentes et d’améliorer les fonctionnalités plus rapidement.

Docker, en particulier, a émergé comme un outil pionnier dans le domaine de la conteneurisation. Grâce à ses fonctionnalités intuitives, il permet de créer, déployer et gérer des conteneurs avec une grande facilité. Cependant, à mesure que le nombre de conteneurs déployés augmente, gérer ces conteneurs devient une tâche complexe. C’est ici qu’intervient Kubernetes, un système d’orchestration qui facilite la gestion des conteneurs à grande échelle. Kubernetes permet non seulement de déployer des conteneurs sur un cluster, mais aussi de gérer leur montée et descente en charge, leur mise à jour, et leur santé.

En somme, avec la montée de la conteneurisation, des outils comme Docker et Kubernetes deviennent essentiels pour optimiser les infrastructures informatiques, offrant flexibilité et efficacité dans un paysage technologique en constante évolution.

Comprendre Docker : le conteneur léger

Docker est une plateforme logicielle qui permet aux développeurs de créer, tester et déployer des applications rapidement à l’aide de conteneurs. Ces conteneurs fournissent un environnement isolé dans lequel une application et toutes ses dépendances peuvent fonctionner de manière cohérente, quel que soit l’environnement d’exécution sous-jacent. Ce mécanisme de conteneurisation facilite le transfert et la gestion des applications, réduisant ainsi les problèmes de compatibilité souvent rencontrés dans les systèmes traditionnels.

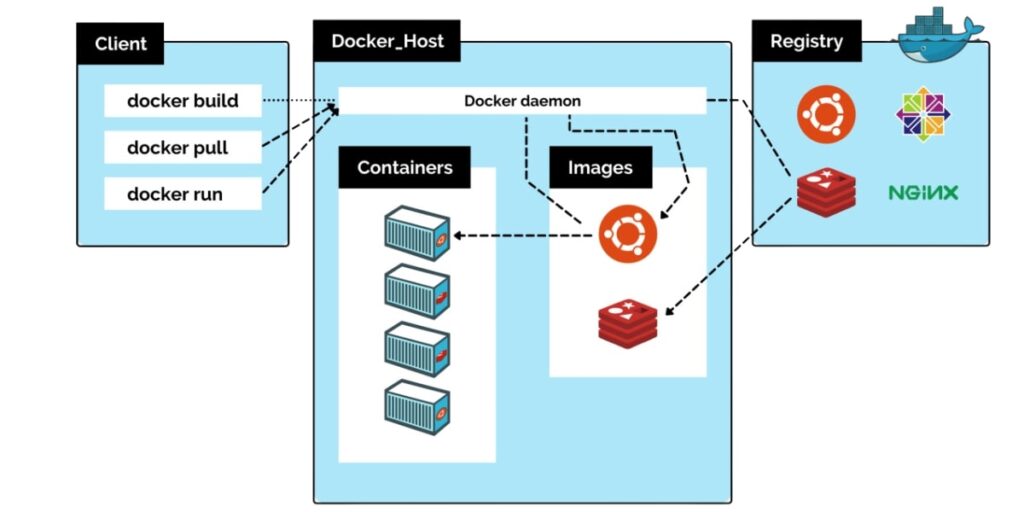

Les composants principaux de Docker incluent le moteur Docker, l’outil en ligne de commande et le registre Docker. Le moteur Docker est responsable de la création et de l’exécution des conteneurs. Il utilise des images Docker, qui sont des modèles en lecture seule à partir desquels les conteneurs sont générés. L’outil en ligne de commande, quant à lui, permet aux utilisateurs d’interagir avec le moteur Docker pour gérer ces images et conteneurs. Le registre Docker stocke et distribue les images, facilitant leur partage entre les développeurs et les équipes.

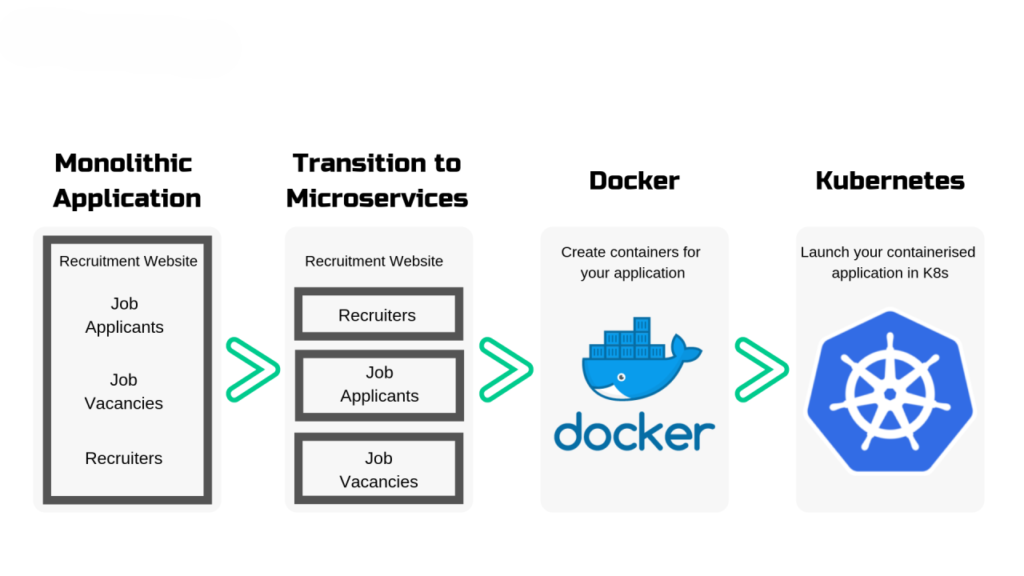

Docker est largement utilisé pour le développement d’applications microservices, où des services distincts sont encapsulés dans des conteneurs individuels, permettant une mise à l’échelle et une mise à jour indépendantes. En outre, Docker améliore l’efficacité des pipelines d’intégration continue et de déploiement continu (CI/CD), permettant une livraison rapide et fiable des nouvelles fonctionnalités et corrections de bugs. L’approche de Docker en matière de gestion des conteneurs permet également d’accélérer les cycles de développement, car les développeurs peuvent facilement configurer et démarrer leurs environnements locaux sans nécessité de ressources excessives.

En résumé, Docker se positionne comme un outil essentiel pour les développeurs cherchant à optimiser leurs processus de développement et à garantir la portabilité des applications. Grâce à sa capacité à créer des conteneurs légers et à rationaliser la gestion des environnements d’exécution, il offre des avantages notables dans le paysage technologique actuel.

Kubernetes : l’orchestrateur de conteneurs

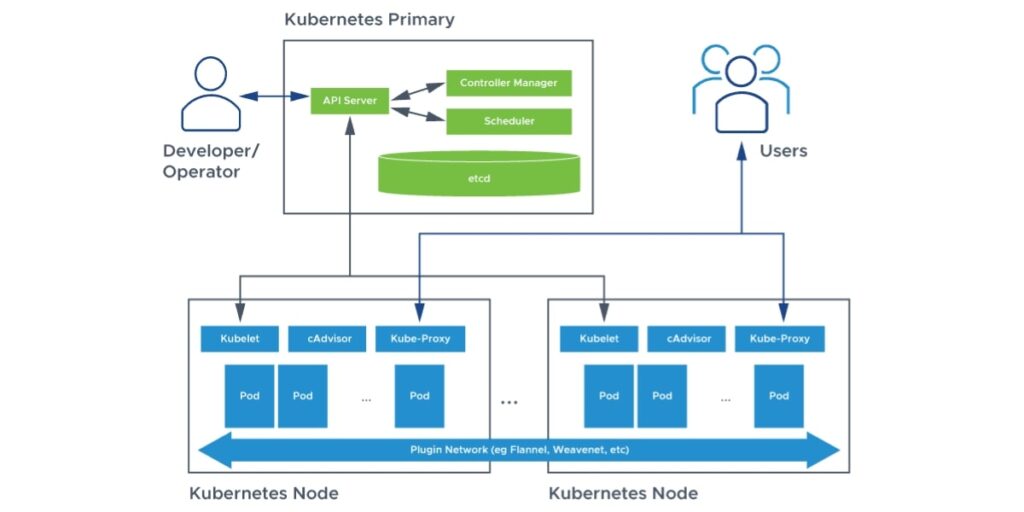

Kubernetes, souvent désigné comme K8s, est un système open-source de gestion d’orchestration de conteneurs qui facilite l’automatisation du déploiement, de la mise à l’échelle et de l’exploitation d’applications conteneurisées. À mesure que l’utilisation de conteneurs se développe, Kubernetes s’impose comme une solution incontournable pour les entreprises cherchant à optimiser leurs infrastructures. Son architecture est construite autour de plusieurs composants clés, dont les pods, qui sont les plus petites unités de déploiement dans Kubernetes.

Les pods peuvent contenir un ou plusieurs conteneurs qui partagent le même réseau et le même stockage, ce qui permet une gestion efficace des ressources. En ajoutant des services, Kubernetes facilite la découverte et la communication entre les différentes applications déployées, rendant le processus non seulement simplifié mais aussi remarquablement flexible. Cette approche modulaire offre un contrôle granulaire sur la synchronisation et la mise à l’échelle, s’adaptant facilement aux besoins changeants des applications modernes.

Un autre aspect essentiel de Kubernetes est sa capacité à gérer la mise en réseau. Kubernetes met en œuvre un modèle de réseau plat, où chaque conteneur peut communiquer avec tous les autres conteneurs, sans avoir besoin de NAT, ce qui facilite la connexion des services dans un cluster. De plus, Kubernetes offre des options avancées pour la gestion du volume de données, garantissant que les données sont non seulement sécurisées mais également accessibles par les conteneurs, même en cas de défaillance d’un pod.

En somme, Kubernetes se distingue par sa robustesse et sa flexibilité comparativement à d’autres solutions de gestion de conteneurs. Ses fonctionnalités avancées, telles que l’automatisation du déploiement et la mise à l’échelle dynamique, permettent aux entreprises de tirer pleinement parti de la conteneurisation, offrant un environnement de développement et de production optimisé pour 2024 et au-delà.

Comparaison approfondie entre Docker et Kubernetes

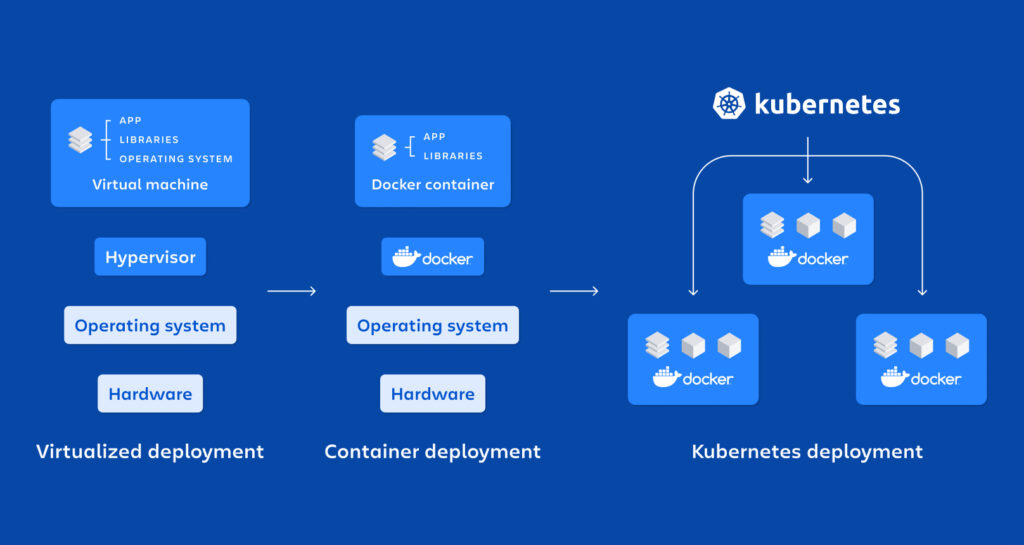

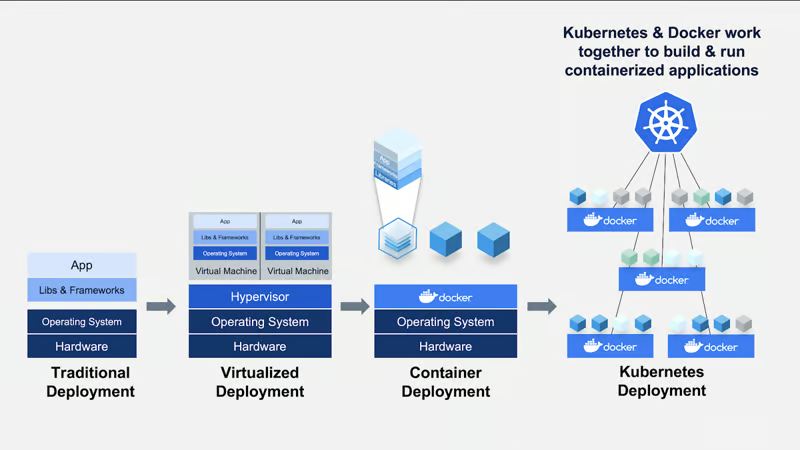

Docker et Kubernetes sont deux technologies souvent confondues, bien qu’elles servent des objectifs distincts dans le domaine de la gestion des conteneurs. Docker est principalement un outil utilisé pour créer, déployer et exécuter des conteneurs, permettant aux développeurs de regrouper une application et toutes ses dépendances dans un environnement léger et portable. En revanche, Kubernetes est un système d’orchestration qui gère et automate le déploiement, la mise à l’échelle et l’administration des conteneurs, y compris ceux créés avec Docker.

Les différences fondamentales entre Docker et Kubernetes résident dans leurs fonctionnalités et leur utilisation. Docker se concentre sur l’emballage d’applications, tandis que Kubernetes fournit une infrastructure robuste qui permet aux équipes DevOps de gérer des clusters de conteneurs. À cette fin, Kubernetes offre des fonctionnalités avancées telles que la mise à l’échelle automatique des applications, le déploiement sans temps d’arrêt et la gestion du réseau entre les conteneurs.

Il est essentiel de comprendre comment les deux technologies interagissent. Docker peut fonctionner de manière indépendante; cependant, lorsqu’il est intégré à Kubernetes, il permet une orchestration efficace. Ensemble, ils offrent une solution puissante pour le déploiement d’applications modernes, particulièrement dans des contextes nécessitant une gestion dynamique des ressources.

Des experts du secteur soulignent que dans des scénarios où une gestion simple des conteneurs est requise, comme le développement local ou des applications de petite taille, Docker seul peut suffire. Toutefois, pour les grandes entreprises cherchant à déployer des applications complexes sur plusieurs serveurs, Kubernetes devient essentiel. En effet, sa capacité à gérer plusieurs conteneurs simultanément et à orchestrer leurs interactions en fait un atout précieux pour toute infrastructure au sein de l’écosystème cloud.

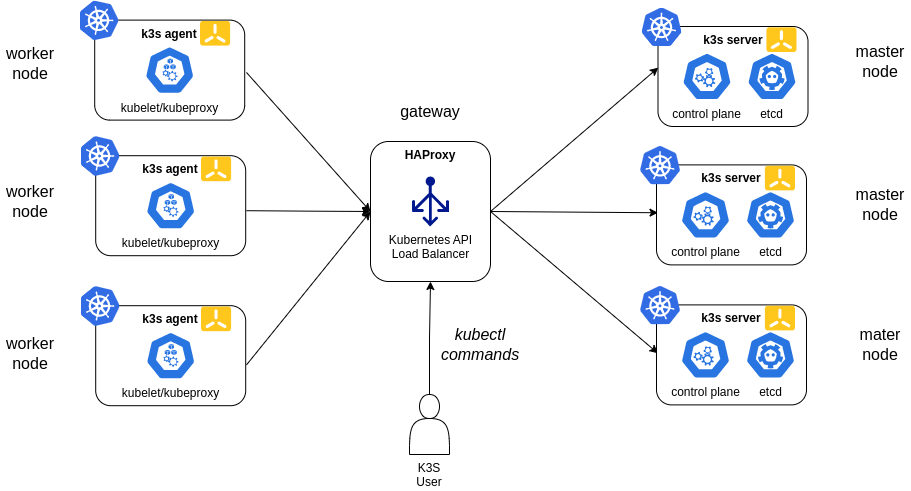

K3s : une version allégée de Kubernetes

K3s est une distribution de Kubernetes simplifiée, conçue spécifiquement pour fonctionner efficacement dans des environnements aux ressources limitées. Développée par Rancher Labs, K3s offre une solution robuste pour déployer des applications conteneurisées tout en réduisant la complexité souvent associée à l’utilisation de Kubernetes traditionnel. Grâce à sa taille réduite et à son installation simplifiée, K3s est idéal pour des projets nécessitant une gestion des conteneurs dans des environnements tels que l’Internet des objets (IoT) ou sur des machines virtuelles à faible capacité.

Une des principales caractéristiques de K3s est sa légèreté. En consommant moins d’espace mémoire et de puissance de traitement, K3s permet aux développeurs de déployer des systèmes d’orchestration dans des environnements qui seraient normalement inaccessibles pour les versions complètes de Kubernetes. Ceci est particulièrement apprécié dans des situations où les ressources sont rares, comme dans les projets de développement, les environnements de test ou même sur des machines locales. De plus, K3s est conçu pour s’installer facilement avec une seule commande, ce qui le rend attrayant pour les développeurs cherchant à gagner du temps.

Un autre avantage clé de K3s réside dans sa compatibilité avec les applications Kubernetes standard. Les utilisateurs peuvent bénéficier de la richesse de l’écosystème Kubernetes, tout en profitant d’une empreinte réduite. Cela signifie que même les petits projets peuvent profiter des fonctionnalités avancées de gestion de conteneurs offertes par Kubernetes sans la lourdeur de l’installation classique. En adoptant K3s, les équipes peuvent donc réaliser leurs tests et expérimentations plus rapidement, ce qui est essentiel dans le cycle de développement agile d’aujourd’hui.

Quand utiliser Docker ou Kubernetes ?

Le choix entre Docker et Kubernetes dépend principalement des besoins spécifiques de votre application et des objectifs de votre infrastructure. Docker est un outil de conteneurisation qui permet de créer, déployer et gérer des applications en conteneurs de manière simple et efficace. En revanche, Kubernetes est une plateforme d’orchestration qui permet de gérer des applications conteneurisées à grande échelle. Il est donc essentiel d’évaluer plusieurs facteurs avant de décider quelle solution utiliser, seule ou en combinaison.

Tout d’abord, la taille de l’application joue un rôle crucial dans cette décision. Pour les petites applications ou les projets pilotes, Docker seul peut suffire. Il offre une simplicité qui facilite le déploiement sans nécessiter une infrastructure d’orchestration complexe. Cependant, à mesure que l’application se développe et que le nombre de conteneurs augmente, les défis de gestion et d’interconnexion se multiplient. Dans de tels cas, Kubernetes devient pertinent, car il permet d’automatiser le déploiement, la mise à l’échelle et la gestion du cycle de vie des conteneurs.

Un autre critère à considérer est le niveau de complexité requis pour l’orchestration. Si votre architecture microservices comporte de nombreuses dépendances et services interconnectés, Kubernetes peut simplifier ces interactions grâce à sa capacité de gestion avancée. En revanche, si votre application est relativement simple et nécessite peu d’interactions, Docker peut répondre à vos besoins sans la surcharge d’une solution d’orchestration.

Enfin, la nécessité de déployer à grande échelle est un facteur déterminant. Dans un environnement à forte demande, Kubernetes excelle par sa capacité à gérer plusieurs conteneurs, assurer une disponibilité constante et équilibrer la charge de travail. Pour des déploiements plus modestes, Docker peut suffire, permettant une approche plus directe sans complications supplémentaires. En conclusion, évaluer ces critères vous aidera à choisir entre Docker, Kubernetes, ou une combinaison des deux, en fonction des besoins uniques de votre projet.

Meilleures pratiques pour mettre en œuvre Docker et Kubernetes

Dans le déploiement et la gestion des conteneurs, l’adoption de meilleures pratiques pour Docker et Kubernetes est essentielle afin d’assurer la sécurité, l’efficacité et la scalabilité de vos infrastructures. Tout d’abord, en matière de sécurité, il est crucial de suivre les recommandations d’experts pour le durcissement des conteneurs. Cela inclut l’utilisation d’images de conteneurs minimales et vérifiées, l’activation des contrôles d’accès basés sur les rôles (RBAC) dans Kubernetes, ainsi que la mise en place de réseaux sécurisés pour les communications entre conteneurs.

La gestion des versions des conteneurs est un autre aspect important. Il est recommandé d’utiliser des tags de version clairs et descriptifs pour vos images Docker, facilitant ainsi l’identification des changements et la gestion des déploiements. L’intégration des systèmes de gestion de configuration, tels que Helm pour Kubernetes, peut également être bénéfique pour maintenir la cohérence à travers les différentes versions de votre application.

L’orchestration des conteneurs nécessite une attention particulière, spécialement dans des environnements de production. Il est conseillé d’implémenter des stratégies de redémarrage et de mise à l’échelle automatique afin de gérer efficacement la charge de travail. Par ailleurs, le suivi et la surveillance des performances des conteneurs sont fondamentaux pour identifier les goulets d’étranglement et les problèmes de performance. L’utilisation d’outils comme Prometheus et Grafana peut fournir des insights précieux sur le fonctionnement de votre architecture basée sur des conteneurs.

Enfin, il est bénéfique d’apprendre à travers des cas d’utilisation réels, qui mettent en lumière les défis et les solutions apportées par l’audit de l’utilisation de Docker et Kubernetes. Cette expérience pratique peut aider à approfondir votre compréhension de ces technologies et à optimiser vos infrastructures pour 2024 et au-delà.

Ressources supplémentaires

Pour ceux qui désirent approfondir leurs connaissances sur Docker, Kubernetes et la conteneurisation, plusieurs ressources sont disponibles afin de faciliter l’apprentissage et l’application de ces technologies. Ces ressources incluent des articles, des livres, des tutoriels et des conférences, chacun offrant une perspective unique sur l’orchestration et la gestion des conteneurs.

Premièrement, les articles techniques publiés dans des revues et sur des blogs de l’industrie peuvent être particulièrement instructifs. Des plateformes comme Medium, Dev.to et les blogs officiels de Docker et Kubernetes proposent régulièrement des publications détaillées et des études de cas pratiques. Ces articles abordent des sujets allant des bases de la conteneurisation aux meilleures pratiques en matière de déploiement dans des environnements complexes.

En ce qui concerne les livres, plusieurs ouvrages font autorité dans le domaine. Des titres comme « Kubernetes Up & Running » et « Docker Deep Dive » fournissent des explications approfondies et se basent sur des exemples réels pour aider les lecteurs à comprendre les concepts avancés. Ces livres sont particulièrement utiles tant pour les débutants que pour les professionnels souhaitant se perfectionner.

Les tutoriels en ligne peuvent également être d’une grande aide. Des sites tels que Udemy, Coursera et Pluralsight offrent des cours complets sur Docker et Kubernetes, permettant aux apprenants de suivre des modules à leur rythme. Ces cours incluent souvent des exercices pratiques qui renforcent les compétences acquises.

Enfin, des conférences et des meetups sont organisés régulièrement autour de Docker et Kubernetes. Ces événements constituent une excellente occasion de se connecter avec des experts de l’industrie, d’apprendre des nouvelles tendances et de partager des expériences. Les conférences telles que KubeCon et DockerCon permettent d’explorer des sujets en profondeur et d’interagir avec des professionnels partageant des intérêts similaires.

FAQ sur la conteneurisation, Docker et Kubernetes

La conteneurisation est devenue un sujet central pour les développeurs et les responsables informatiques. Plusieurs questions se posent fréquemment concernant cette technologie, en particulier autour de Docker et Kubernetes. Voici quelques-unes des questions les plus posées, accompagnées de réponses concises mais informatives.

1. Qu’est-ce que la conteneurisation ?

La conteneurisation est une méthode qui permet d’emballer une application et toutes ses dépendances dans un conteneur léger et portable. Cela garantit que l’application s’exécutera de manière cohérente dans différents environnements, qu’ils soient de développement, de test ou de production.

2. Quelle est la différence entre Docker et Kubernetes ?

Docker est une plateforme qui facilite la création, le déploiement et la gestion de conteneurs. En revanche, Kubernetes est un système d’orchestration qui gère les conteneurs déployés à grande échelle, assurant leur fonctionnement et leur scalabilité. Alors que Docker se concentre sur un seul conteneur, Kubernetes se concentre sur la gestion de plusieurs conteneurs.

3. Pourquoi devrais-je utiliser des conteneurs ?

L’utilisation de conteneurs permet d’améliorer l’efficacité des ressources, de renforcer la portabilité des applications et de simplifier les processus de déploiement. Les conteneurs isolent les applications, réduisant ainsi les conflits entre les environnements et accélérant le temps de mise sur le marché.

4. Kubernetes est-il complexe à apprendre ?

Kubernetes a une courbe d’apprentissage plus raide que Docker, en raison de sa richesse fonctionnelle. Cependant, des ressources abondent, telles que des tutoriels et la documentation officielle, qui facilitent l’apprentissage et la compréhension de ses concepts fondamentaux.

5. Quels sont les cas d’utilisation typiques de Kubernetes ?

Kubernetes est particulièrement adapté pour les applications modernes basées sur des microservices, le déploiement en continu, et la gestion d’infrastructures cloud. Il permet également l’automatisation du déploiement et de la mise à l’échelle des applications.